Gemini 2.0 : Google DeepMind donne des bras (et du cerveau) aux robots

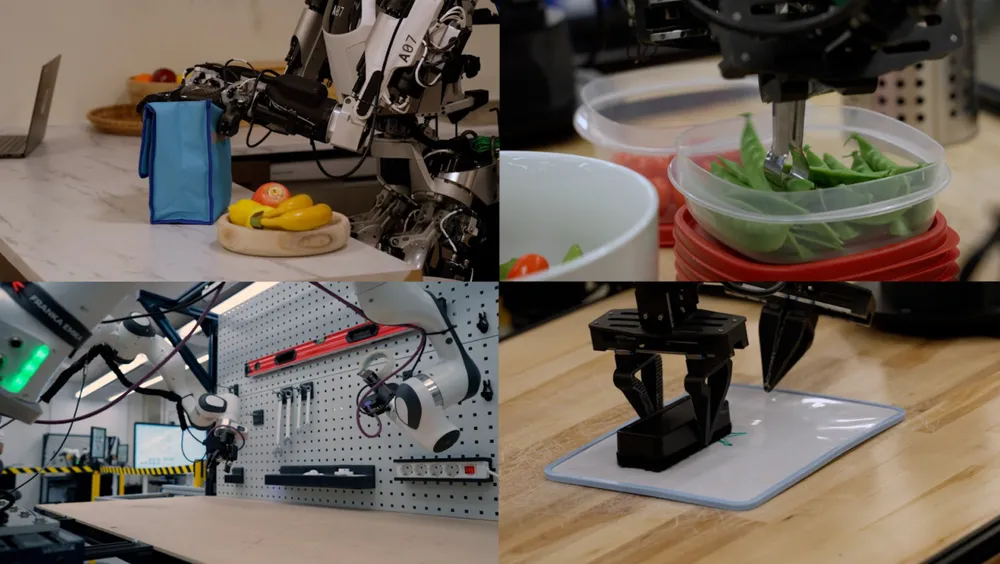

Imaginez un robot capable de faire un slam dunk ou de ranger vos stylos dans une chaussure posée sur la table. Non, ce n’est pas un rêve de fan de science-fiction (ou de flemmard invétéré), c’est la réalité chez Google DeepMind, qui vient de dévoiler sa nouvelle génération de modèles Gemini 2.0, pensés spécialement pour… les robots !

Un robot, deux bras, zéro script

Lors d’une session de test, Carolina Parada, la responsable de la robotique chez DeepMind, et son équipe ont mis à l’épreuve un robot ALOHA à deux bras articulés. Le défi ? Accomplir des tâches jamais vues, avec des objets inconnus. Comme par exemple : « Tiens, mets ces stylos dans cette chaussure. » Le robot a réfléchi un instant, puis… mission accomplie.

Encore plus impressionnant : il a ensuite réussi un slam dunk avec un mini-panier de basket. À la première tentative. Sans entraînement spécifique. De quoi déclencher des « waouh » chez les ingénieurs (et probablement quelques crises existentielles chez les basketteurs humains).

Gemini Robotics : une IA multimodale qui bouge

Le cerveau derrière cette prouesse ? Un modèle de la famille Gemini Robotics, fine-tuné avec des données spécifiques à la robotique. Il s’agit de modèles multimodaux — comprenez capables de gérer du texte, de l’image, de l’audio et maintenant des actions physiques. Une révolution pour les robots qui peuvent enfin sortir de leurs scripts figés et improviser face à l’inconnu.

« Ce jalon pose les bases d’une nouvelle génération de robots utiles dans un grand nombre de situations », a déclaré Sundar Pichai, PDG de Google, lors de l’annonce.

Comprendre + Agir = Robot intelligent

Deux modèles sont à retenir :

Gemini Robotics-ER (pour Embodied Reasoning) : une IA qui comprend la scène, reconnaît objets et positions, anticipe trajectoires et mouvements, puis génère le code pour exécuter les actions. En clair, le robot sait ce qu’il voit, ce qu’il doit faire et comment le faire.

Gemini Robotics : le modèle le plus avancé, qui excelle dans la dextérité (ce que les humains font sans réfléchir mais que les robots ont du mal à gérer). Il peut résoudre des tâches complexes en plusieurs étapes, avec fluidité et efficacité.

Pique-nique, origami et Tic-Tac-Toe

Grâce à ces modèles, les robots de DeepMind ont :

- préparé des salades

- emballé des goûters pour enfants

- plié un renard en origami

- et même joué au Tic-Tac-Toe

L’approche ? Ne plus entraîner les IA sur une seule tâche répétée, mais sur plein de tâches variées. Résultat : les robots généralisent et s’adaptent bien mieux.

Un robot pour chaque mission

Ces modèles s’adaptent à différents types de robots, du bras mécanique académique (comme ALOHA) au robot humanoïde (comme Apollo, créé par Apptronik). Peu importe la forme, ils peuvent :

- préparer une lunchbox.

- ramasser un pois mange-tout.

- effacer un tableau blanc.

Et surtout, ils s’adaptent à leur environnement et à leur mission sans qu’on doive tout leur apprendre à chaque fois.

Le futur, version robotique

Carolina résume bien l’ambition : « Un jour, les robots seront simplement une nouvelle interface pour interagir avec l’IA, comme nos téléphones ou nos ordis. » En attendant, ces avancées nous rapprochent sérieusement d’un futur où les robots feront vraiment… les corvées à notre place.

💡 Et vous, quel serait le premier truc que vous demanderiez à un robot de faire chez vous ?